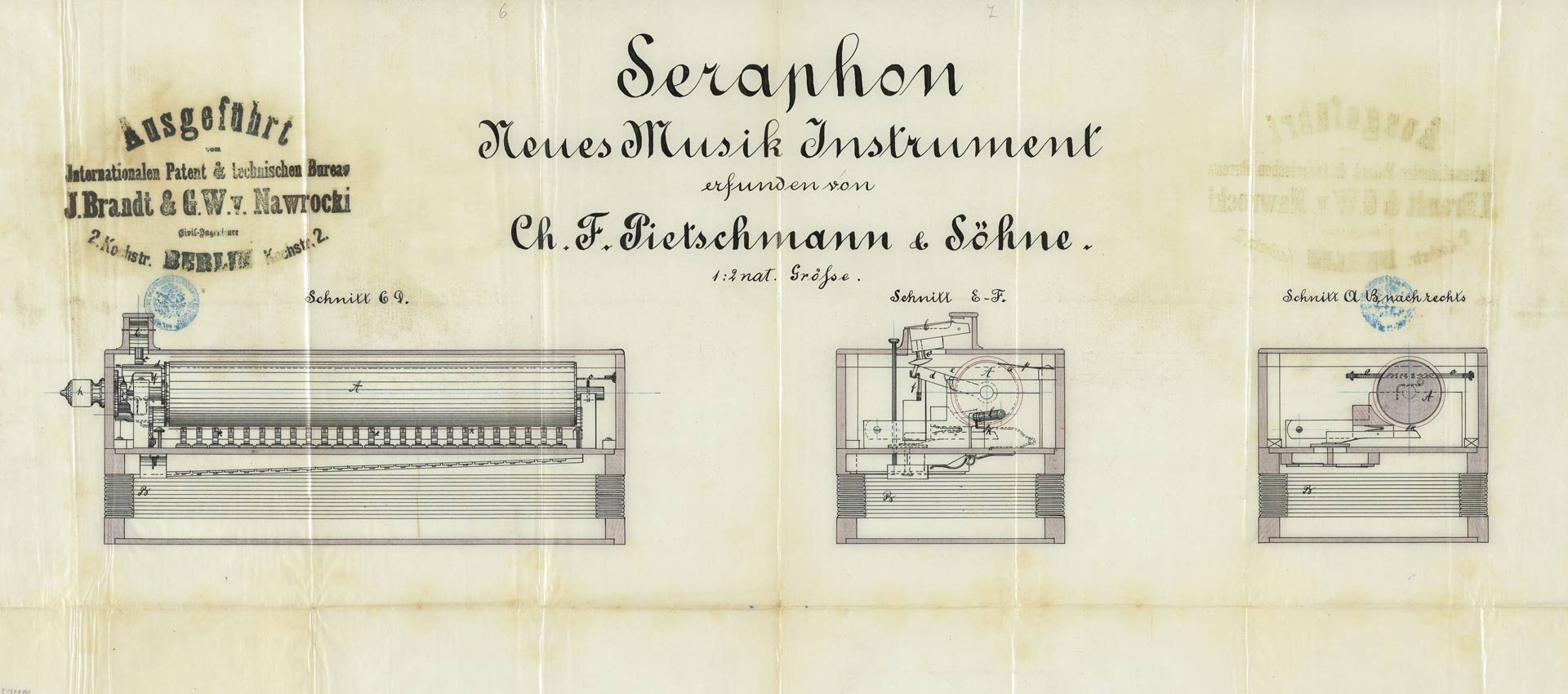

Wie kam es dazu, dass Maschinen Melodien machen? Eine kurze Geschichte der Computermusik, aufgezeichnet von der Kuratorin der „Good Vibrations“-Ausstellung

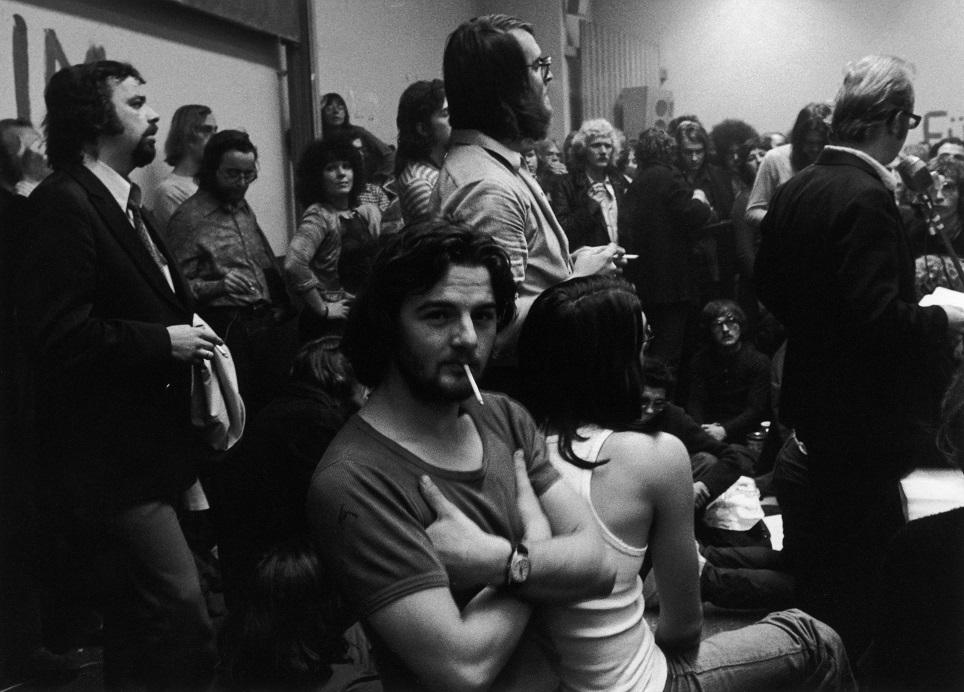

Bei einem gemeinsamen Konzertbesuch Ende der 1950er-Jahren hatten der Elektroingenieur Max Mathews und sein Vorgesetzter John Pierce eine bahnbrechende Idee: Warum nicht ein Computerprogramm schreiben, das musikalische Klänge erzeugen kann? Sie hatten an besagtem Abend Werke von Arnold Schönberg und Artur Schnabel gehört – von ersterem waren die beiden Mitarbeiter der Bell Laboratories in Murray Hill, New Jersey begeistert, von letzteren allerdings eher enttäuscht: Ein Computer könne das besser, soll Pierce damals zu Mathews gesagt haben – und beauftragte ihn dann damit, ein Programm zu entwickeln, das ebendiese Aufgabe erfüllen konnte.

Rund ein Jahr später konnte Mathews mit dem von ihm geschriebenen Music I erstmals ein 17 Sekunden langes Musikstück aufführen. Es war 1957, der ausführende Computer ein IBM 704-Großrechner, und man feierte die Geburtsstunde der Computermusik. Von Pierces Hoffnung einer überzeugenden musikalischen Performance war man zu dieser Zeit allerdings noch weit entfernt; das Programm war zunächst auf experimentelle Anwendungen beschränkt und die Klänge, die es erzeugte, sehr einfach. Lange Rechenzeiten – ein Vielfaches der erzeugten Klangsequenz – und eine Steuerung über maschinennahe Rechenbefehle machten zudem eine Nutzung durch programmiererisch nicht vorgebildete Musiker zunächst undenkbar.

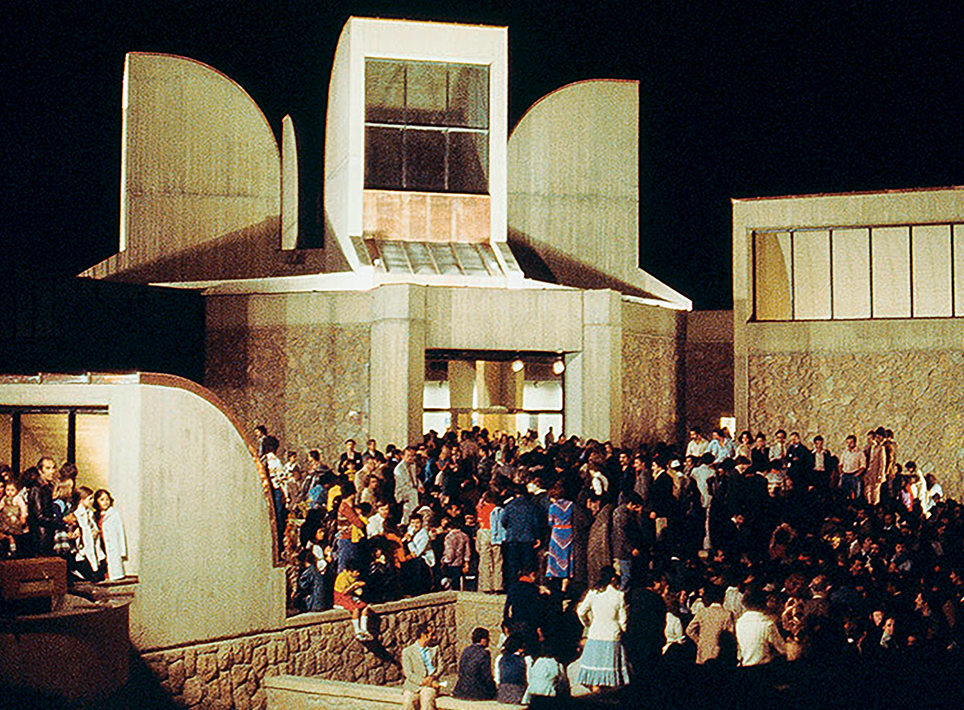

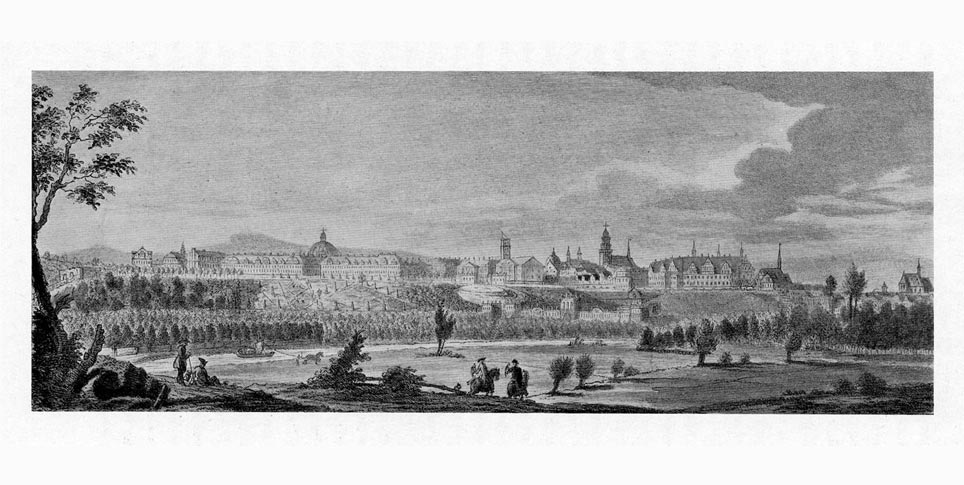

Erst im Laufe der folgenden Jahrzehnte entstanden, nicht zuletzt infolge intensiver Arbeiten an Forschungseinrichtungen wie Princeton, Stanford, dem Massachusetts Institute of Technology (MIT), der University of Illinois sowie dem Pariser Institut de Recherche et Coordination Acoustique/Musique (IRCAM), eine ganze Reihe von Systemen zur Musikprogrammierung, die dank höherer Rechenleistung der verfügbaren Hardware und leichterer Bedienbarkeit allmählich auch Verbreitung unter Musikern fanden.

Computer lernten musizieren – oder komponieren

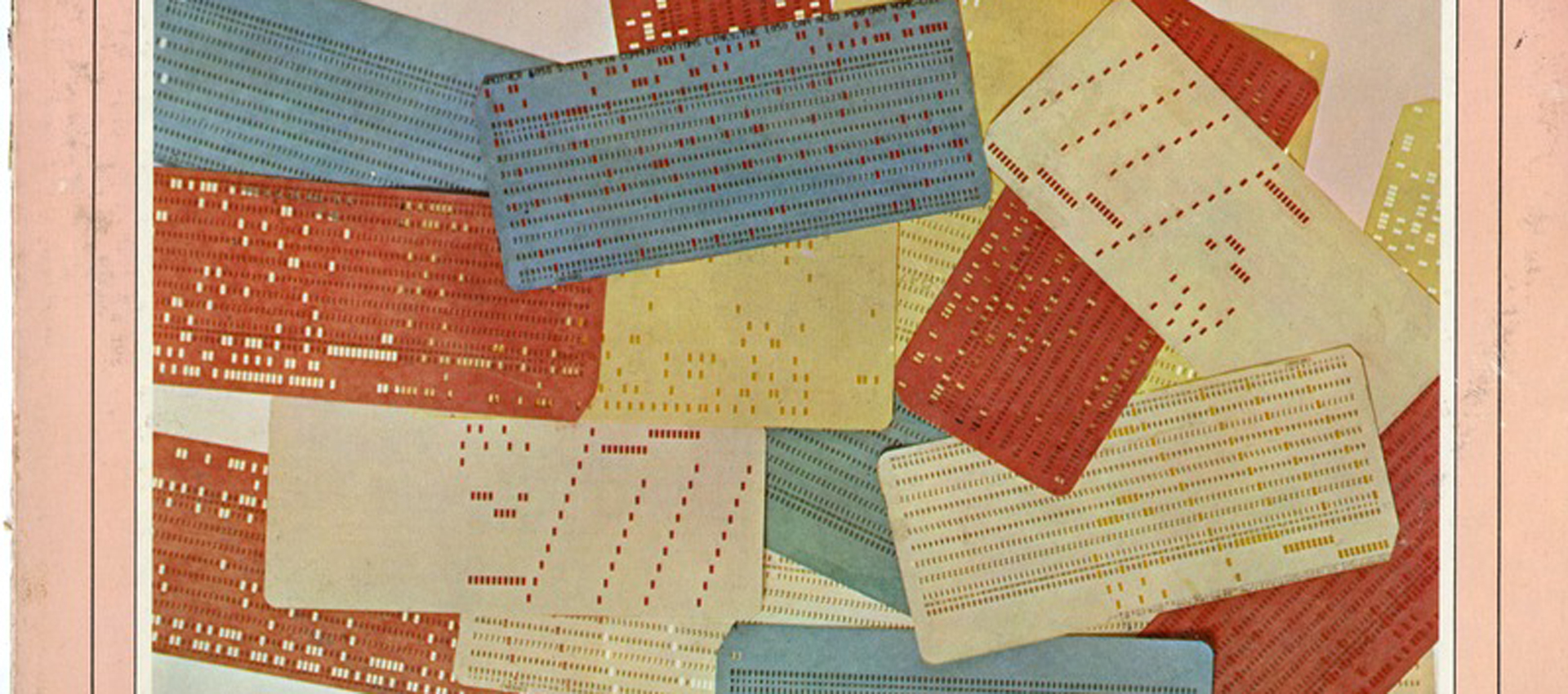

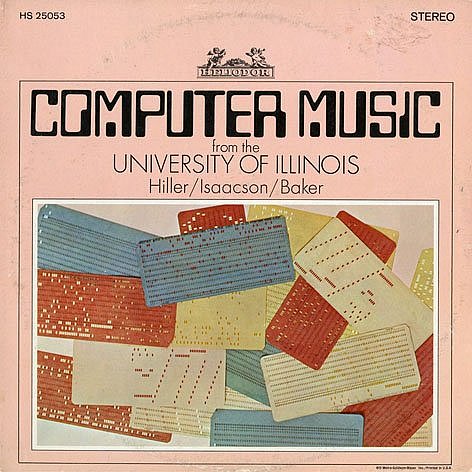

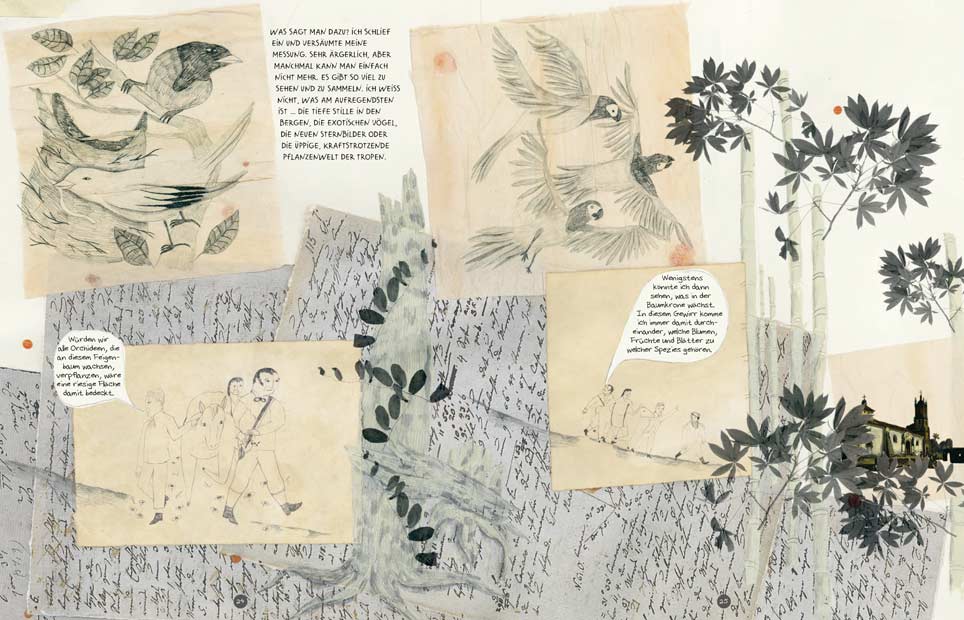

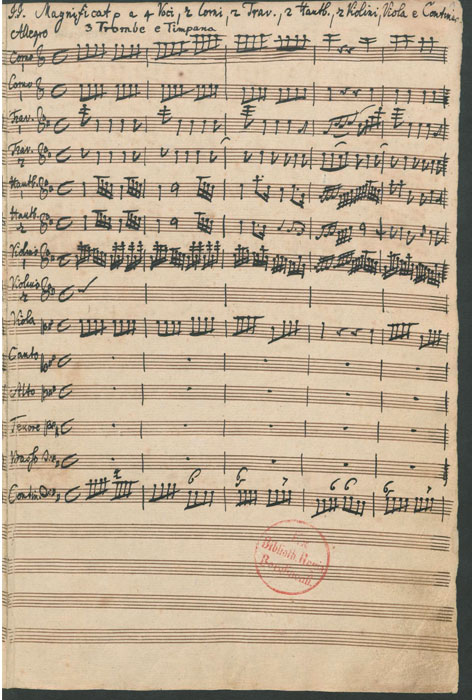

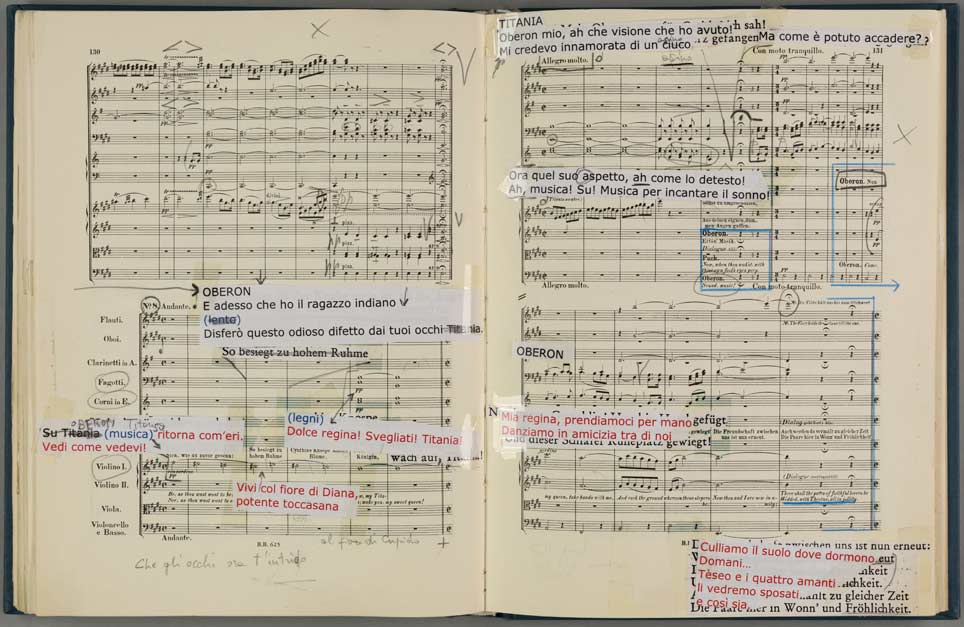

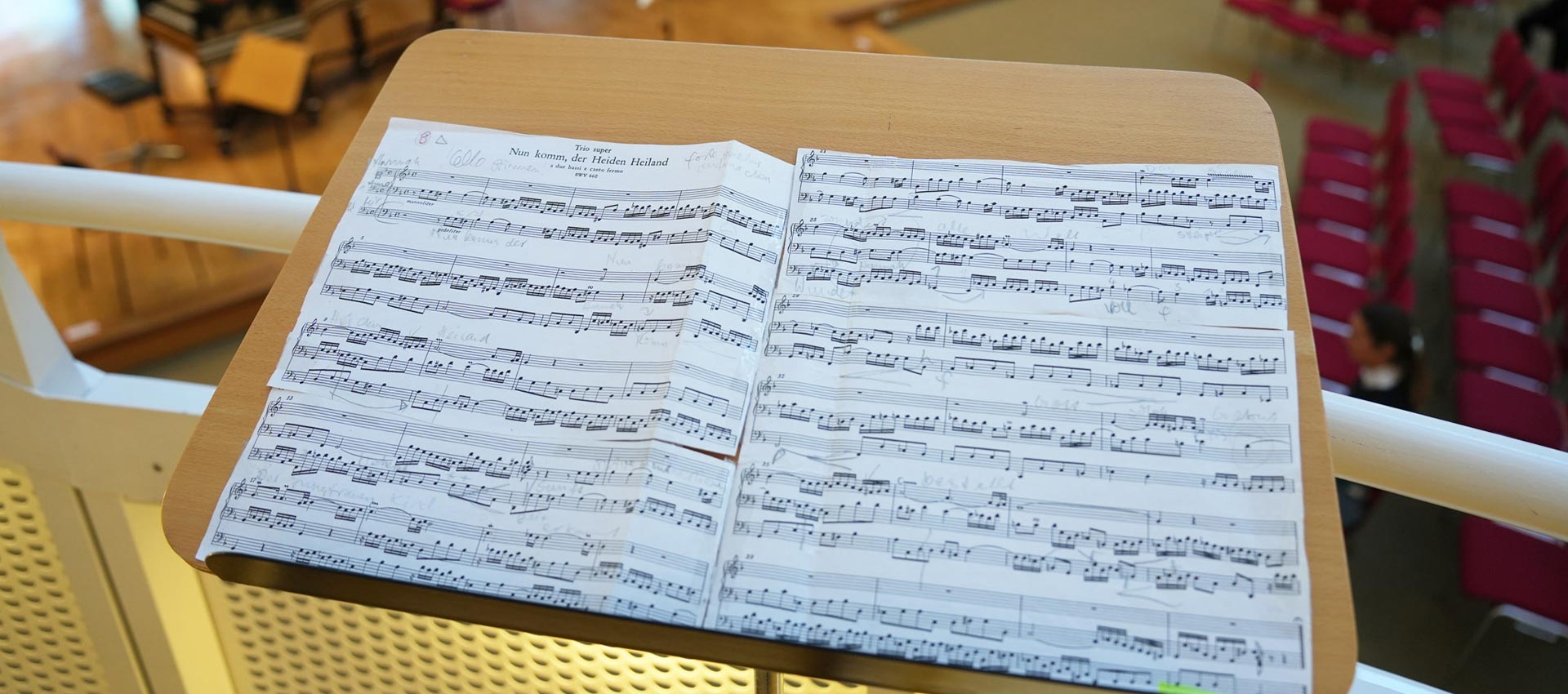

Von Beginn an waren dabei zwei konzeptionell verschiedene Nutzungsschwerpunkte zu unterscheiden: derjenige der Komposition mithilfe des Computers und derjenige der Klangerzeugung mithilfe des Computers. Noch in der Frühzeit der Computermusik finden sich neben den experimentellen Anwendungen von Music I zur Klangerzeugung in den Bell Labs auch Beispiele für eine Nutzung des Computers als rein kompositorisches Mittel: Bereits 1957, also im Jahr der Vorstellung von Music I, errechnete der ILLIAC I-Computer an der University of Illinois nach Vorgaben von Lejaren Hiller und Leonard Isaacson die später in String Quartet No. 4 umbenannte Illiac Suite, das erste von einem Computer komponierte Musikstück. Zu dessen klanglicher Umsetzung wurde allerdings ganz traditionell ein Streichquartett herangezogen, wie es etwas später etwa auch Iannis Xenakis zur Aufführung seiner computergenerierten Partituren praktizierte.

Mit der Rechenleistung späterer Computer, die etwa ab der Jahrtausendwende auch Klangsynthese in Echtzeit ermöglichte, und der Praxis der so genannten algorithmischen Komposition verwischten die Grenzen zwischen den beiden Nutzungsweisen allerdings zusehends, so dass heute bisweilen nicht mehr eindeutig zwischen Prozessen der Komposition und der Echtzeit-Improvisation (mit selbst als „Kompositionen“ zu verstehenden Programmen) zu unterscheiden ist.

Ab den späten 1960er-Jahren erhielten Fragen der Schnittstelle immer größere Bedeutung: Wie konnten die Steuerungsmöglichkeiten des Computers über die Einbindung zusätzlicher Sinneskanäle – etwa mithilfe eines Kathodenstrahlröhrenbildschirms, wie es am MIT erprobt wurde – verbessert werden? Und umgekehrt: Wie ließen sich mithilfe des Computers externe Klangerzeuger – etwa ein analoger Synthesizer, wie es Max Mathews für sein GROOVE-System von 1970 vorsah – steuern?

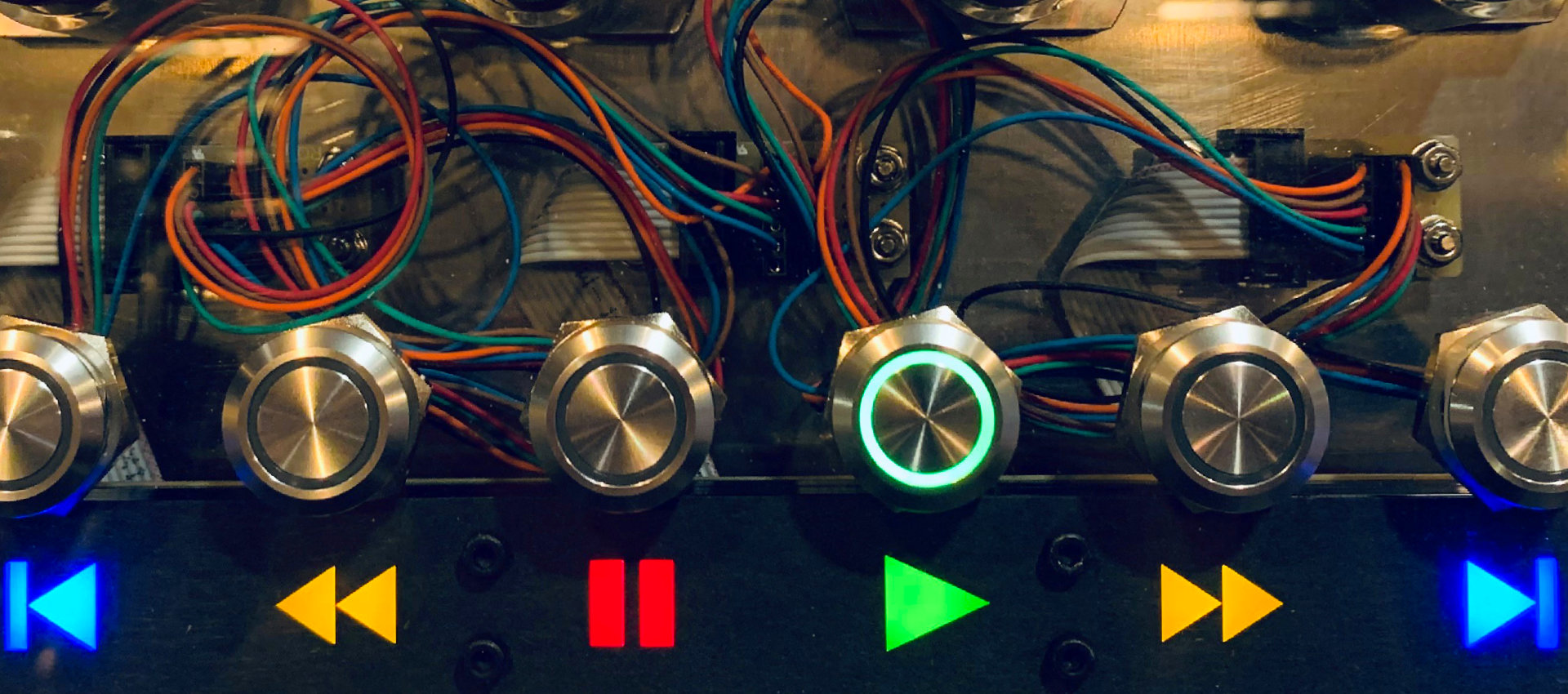

In technischer Hinsicht konnten solche Fragen spätestens 1983, mit der Einführung des MIDI-Standards, eines Kommunikationsprotokolls zur Übertragung musikalischer Steuerdaten, als gelöst gelten. In der Folge konnte der Computer mit vergleichsweise geringem Aufwand etwa zur Steuerung elektronischer Musikinstrumente, aber umgekehrt auch als Klangerzeuger für die nun zahlreich entstehenden so genannten externen Controller herangezogen werden.

Der Rechner wird zur festen Größe im Tonstudio

Zur selben Zeit eroberte der Computer – nun meist in der Form von Heimcomputern – auch die populären Studios und machte sich dort durch effiziente Emulationen ihrer medientechnischen Infrastruktur, etwa in Form von Programmen wie Cubase, Logic oder ProTools, bald unverzichtbar. Bald darauf etablierte sich mit dem VST (Virtual Studio Technology)-Standard der Firma Steinberg auch die Einbindung von Software-Instrumenten in die Produktionsabläufe solcher virtuellen Studios.

So ist der Einsatz des Computers zur Klangerzeugung inzwischen längst zur Selbstverständlichkeit geworden: Programme zur Erzeugung, Bearbeitung, Aufnahme und Wiedergabe von Klängen gehören seit Langem zum virtuellen Werkzeugkasten eines jeden Produzenten, aber eben auch vieler Musiker – zwei ehemals verschiedene Tätigkeitsfelder, die dank Computertechnik immer häufiger auf ein und dieselbe Person entfallen.

Dabei wird der Computer in sehr unterschiedlichem Maße in den musikalischen Gestaltungsprozess einbezogen: Im häufigsten Falle dient er wohl als kompaktes und vielseitiges Studio-Tool, das im Wesentlichen für Aufnahme- und Produktionsverfahren herangezogen wird. Nicht selten wird er aber auch selbst als Musikinstrument eingesetzt oder zumindest als Bestandteil instrumentaler Anordnungen mit deren Klangsynthese betraut.

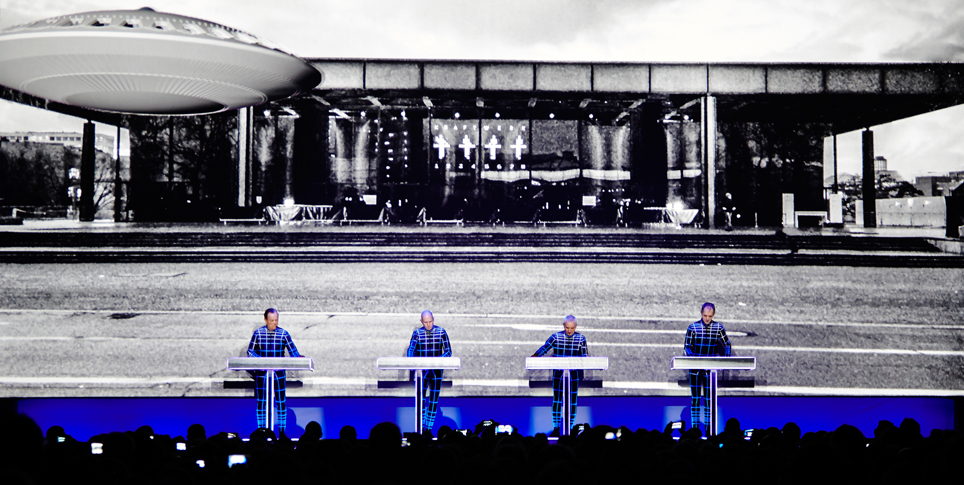

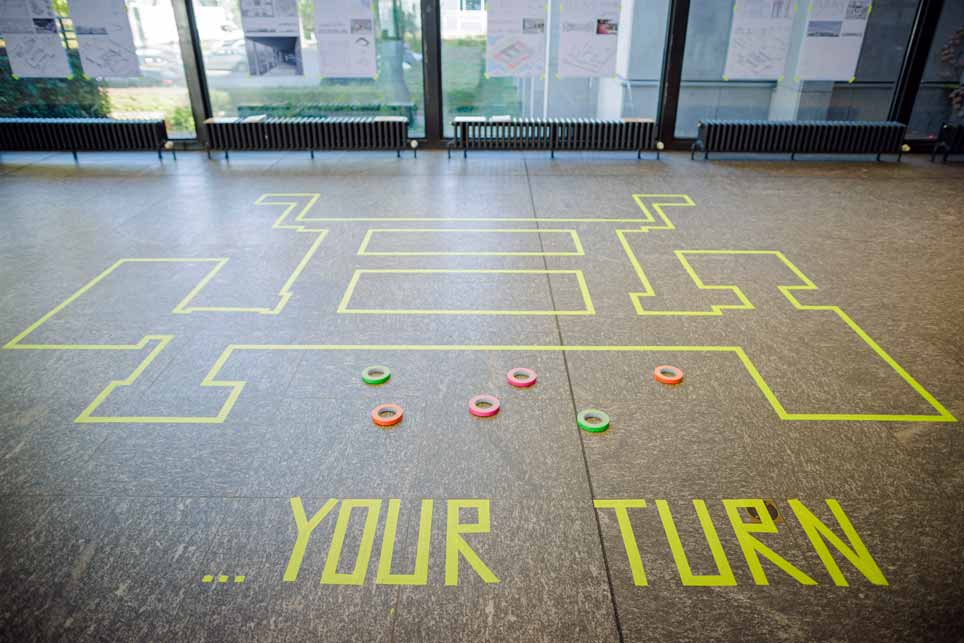

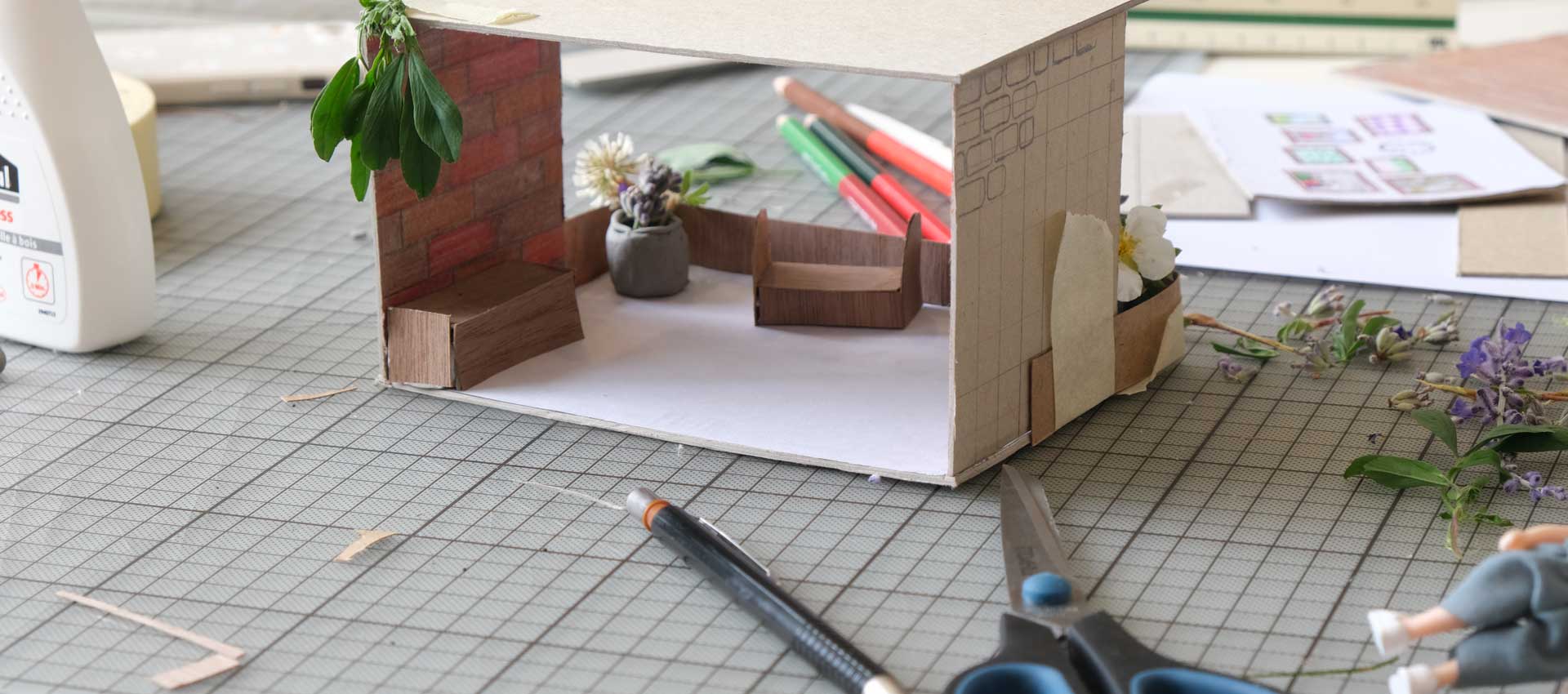

Im Live Coding etwa, einer seit rund 15 Jahren existierenden Live-Praxis, werden mithilfe spezialisierter Programme wie Max/MSP, SuperCollider, ChucK oder Sonic Pi durch das Schreiben von Quellcode in Echtzeit Klänge erzeugt und gesteuert. Dieselben Programme fungieren im Rahmen experimenteller digitaler Interface-Entwicklung als „Sound Engine“, also als Klang erzeugende Komponente, anhand derer ohne großen Aufwand unterschiedliche Sounds erprobt werden können. Im Kontext populärer Musik dienen standardisierte Anordnungen aus Hard- und Software wie Ableton Live und der dedizierte Hardware-Controller Push oder Native Instruments Maschine als performancetaugliche und vielseitige instrumentale Setups, die von ihren Herstellern entsprechend als zeitgenössische Formen des Musikinstruments beworben werden.

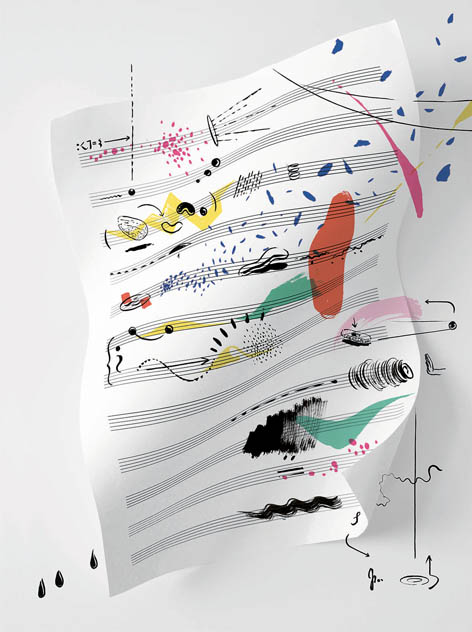

Und schließlich wird, der Tradition Hillers und Isaacsons folgend, bis heute in zahlreichen unterschiedlichen Verfahren der so genannten Algorithmischen Komposition erprobt, wie Computer auf der Grundlage verschiedenster Regelvorgaben eigenständig Kompositionen berechnen – und zu welchen klanglichen Ergebnissen sie dabei kommen. Anders als noch in den 1950er-Jahren werden diese allerdings inzwischen in den meisten Fällen vom Computer selbst ausgegeben, wahlweise als Soundfile oder Partitur.

Welchen Musikgeschmack hat eine Maschine?

Im letzten Jahr machte etwa das von Sony entwickelte KI (Künstliche Intelligenz)-Programm Flow Machines mit einer Reihe von ihm komponierter Popsongs Schlagzeilen, die auf der Auswertung einer musikalischen Datenbank aus unzähligen Titeln verschiedener Stilrichtungen basierten. Das selbstlernende Programm identifizierte charakteristische Stilparameter etwa von Beatles-Songs und setzte die Ergebnisse seiner Analyse zu dem Titel „Daddy’s Car“ zusammen. Für den letzten Schliff wurde dann allerdings doch noch ein menschlicher Songwriter bemüht: Songtext, Arrangement und Produktion oblagen dem französischen Komponisten Benoit Carré, der über den gemeinsamen Schaffensprozess sagt: „Die Maschine bewertet nicht, was sie produziert. Dadurch bin ich umso mehr dazu gezwungen, meine Entscheidungen zu hinterfragen. Warum diese Melodie und nicht die vorige? Mit jedem Schritt zeichnet sich mein Schatten ab. Oder der von Flow Machines, ich weiß es nicht.“ – Im Lichte einer derart ko-operativen Kompositionspraxis scheint Tom Jenkinsons Vision vom Musikmachen als einem gleichberechtigten „Collaborating with Machines“, wie er sie 2004 in seinem ebenso betitelten Manifest formulierte, bereits vollständig erfüllt.

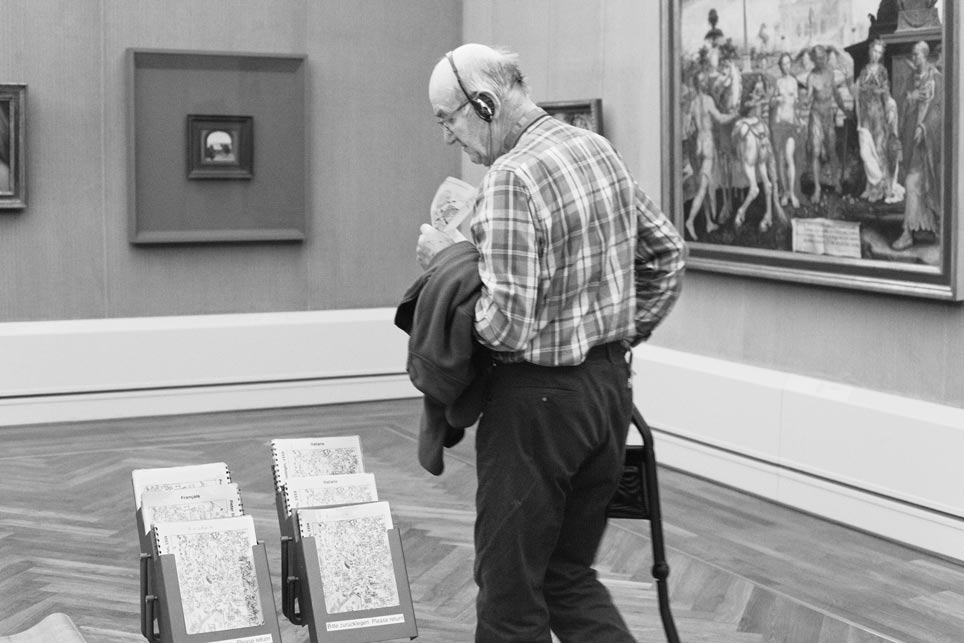

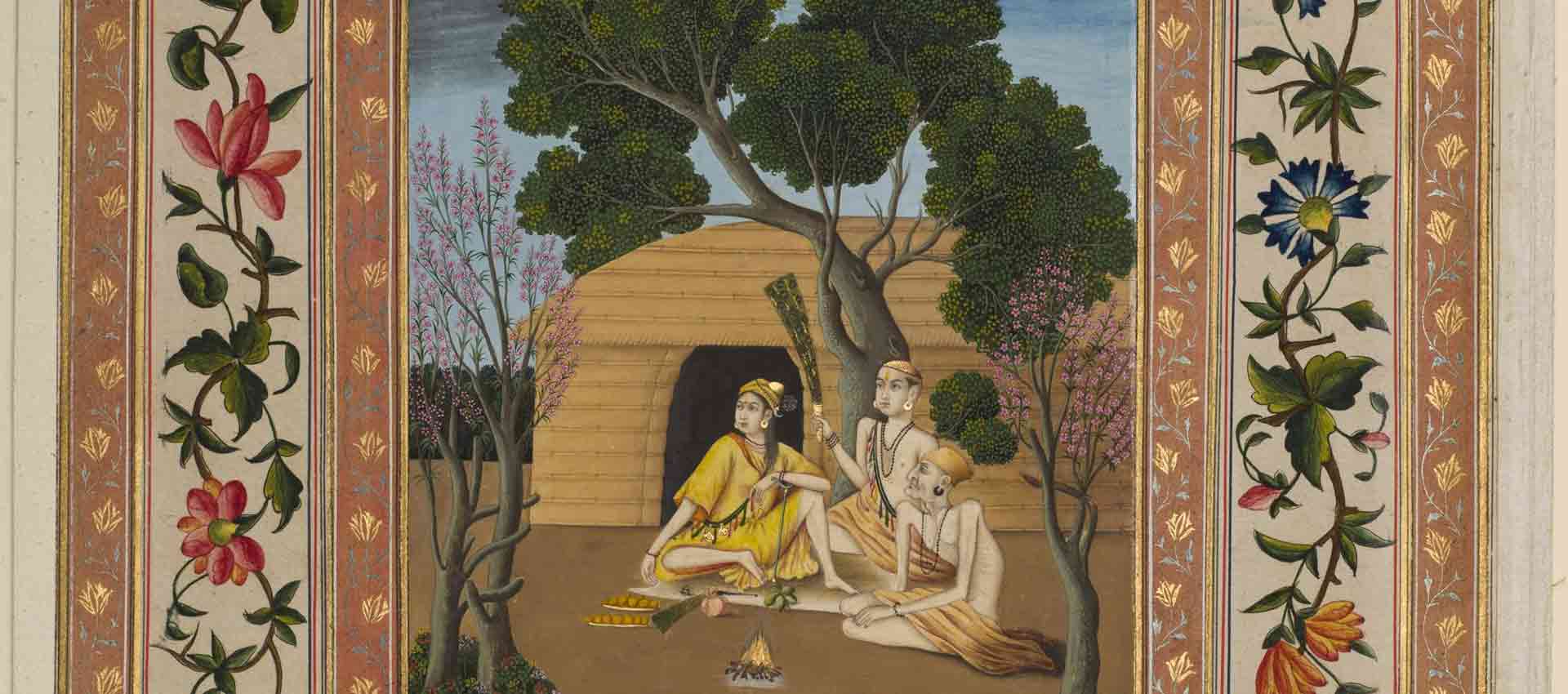

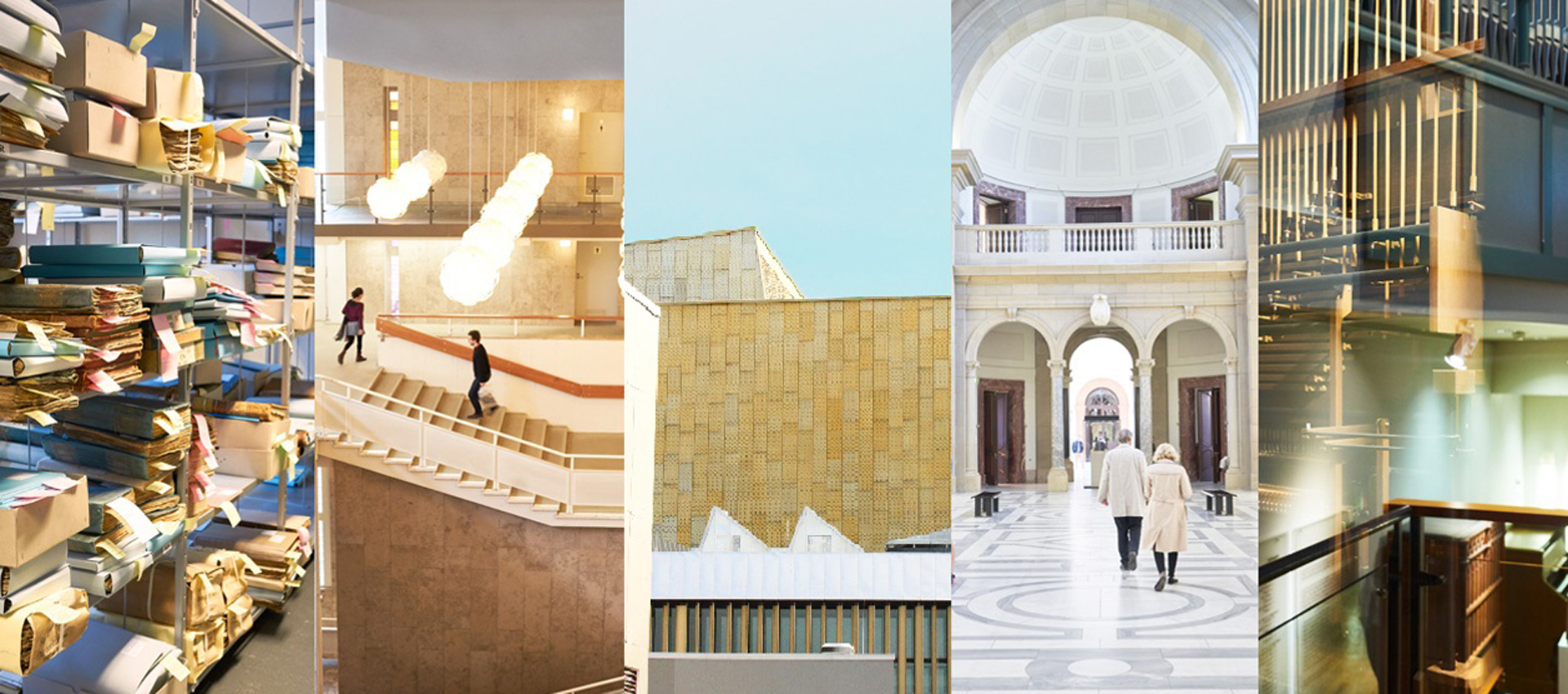

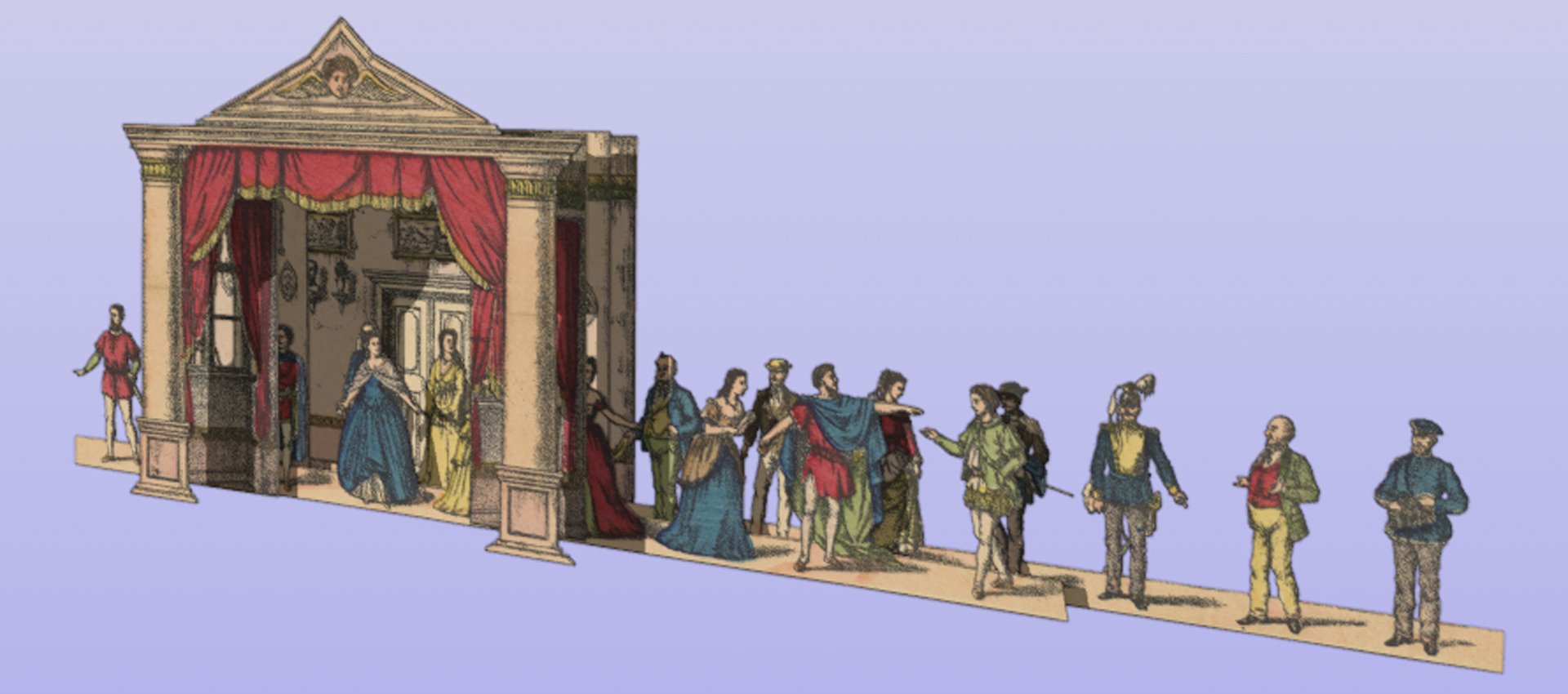

GOOD VIBRATIONS: Eine Geschichte der elektronischen Musikinstrumente

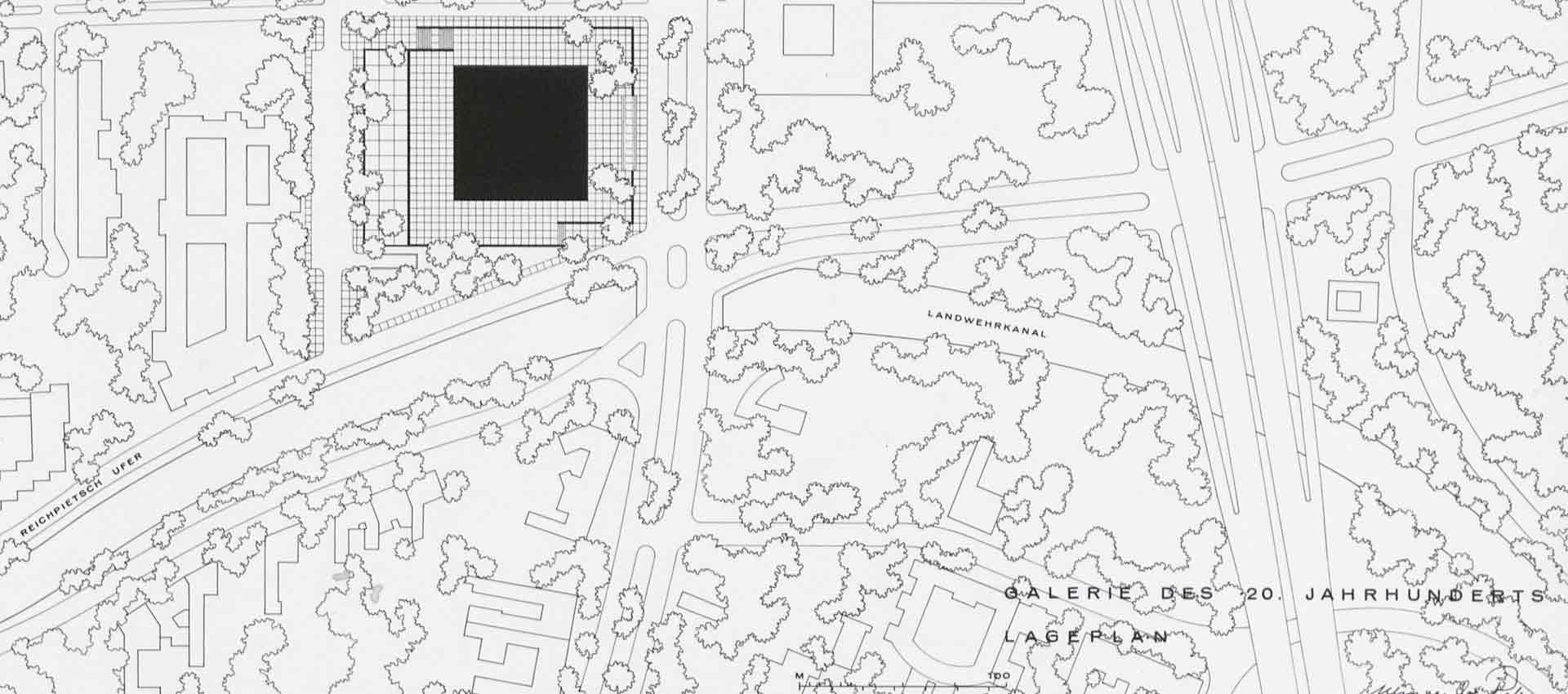

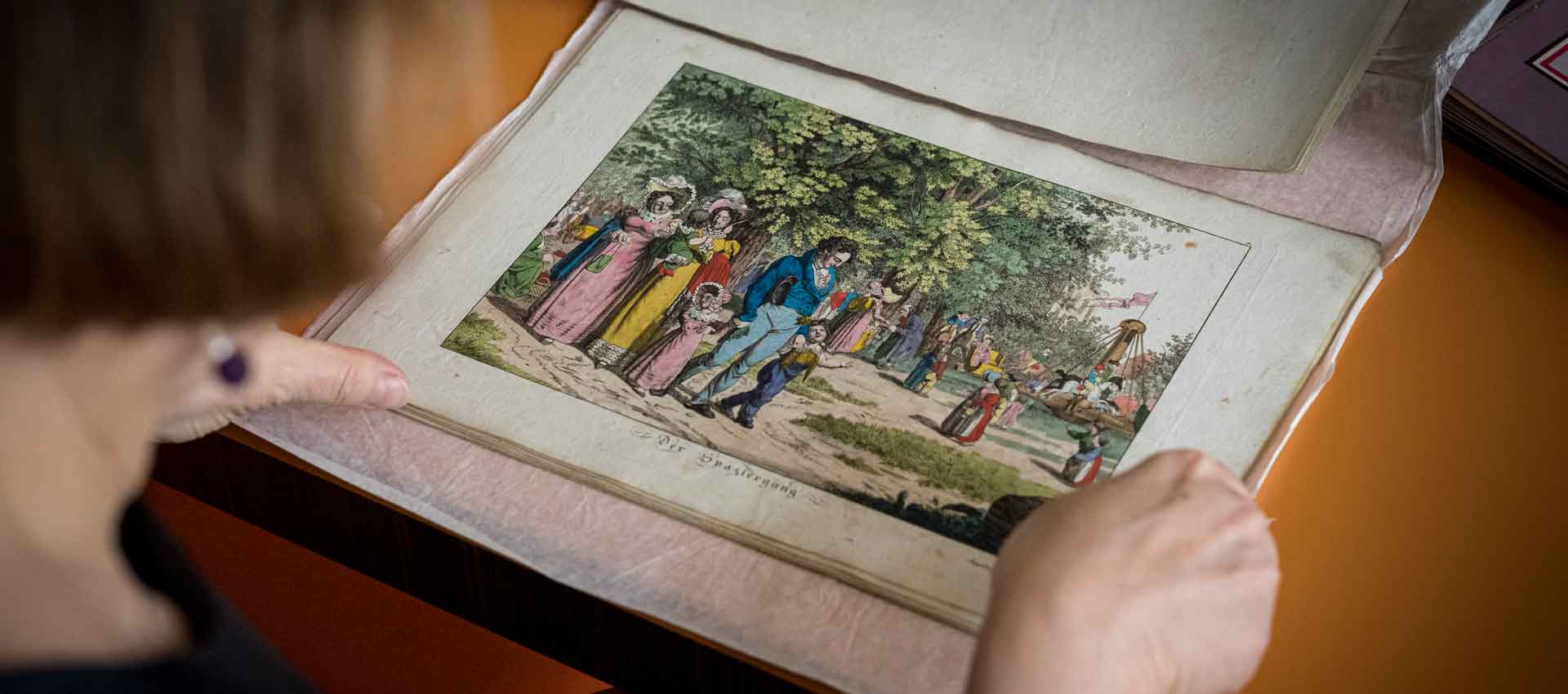

Das Musikinstrumenten-Museum des Staatlichen Instituts für Musikforschung präsentiert vom 25. März bis 27. August 2017 über 60 wegweisende elektronische Musikinstrumente. Dabei werden sowohl die eigenen reichen und bislang kaum gezeigten Bestände als auch Leihgaben internationaler Partner ausgestellt. Das umfangreiche Rahmenprogramm bietet den Besuchern die Chance, viele Instrumente live zu erleben oder sogar selbst zu erproben. Musiker werden ihre Lieblingsinstrumente in Aktion vorstellen und in Workshops Einblicke in deren Spielweisen bieten.

Zum Ausstellungshinweis „GOOD VIBRATIONS. Eine Geschichte der elektronischen Musikinstrumente"